作为一款经典的开源ETL(数据抽取、转换、加载)工具,Kettle凭借其直观的可视化操作界面和强大的数据处理能力,已成为企业数据整合的利器。本文将从零开始详解其安装配置流程,并结合实际应用场景解析其核心功能。

一、Kettle的核心特点与适用场景

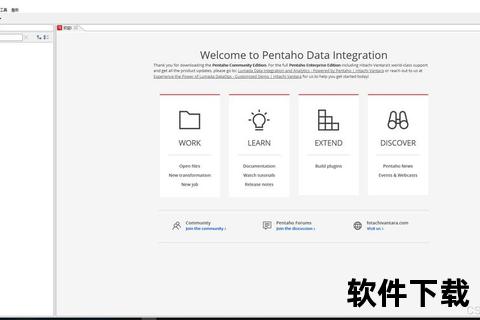

Kettle(现更名为Pentaho Data Integration)采用Java开发,跨平台支持Windows、Linux、MacOS,其核心优势体现在:

1. 零编码开发:通过拖拽式组件构建数据管道,支持数据库、文件、API等30+数据源对接

2. 模块化设计:转换(Transformation)处理单次数据清洗,作业(Job)实现多任务调度与流程控制

3. 开源生态:社区版免费开放,支持通过插件扩展功能,如Hadoop、Spark集成

4. 高性能处理:基于行集缓存机制优化数据传输效率,支持百万级数据量的批量处理

适用领域涵盖数据仓库构建、业务系统迁移、报表自动化生成等场景,尤其适合需要频繁进行异构数据同步的企业。

二、完整安装配置指南

(一)环境准备与工具下载

步骤1:安装JDK 1.8+

shell

JAVA_HOME = C:Program FilesJavajdk-11

Path += %JAVA_HOME%bin

终端执行`java -version`验证安装

步骤2:获取Kettle安装包

(二)解压与基础配置

1. 将压缩包解压至英文路径(如`D:pdi-ce-9.4.0.0-343`),避免中文字符导致启动异常

2. 数据库驱动配置:

3. 内存优化(可选):

编辑`spoon.bat`调整JVM参数,例如:

bat

set PENTAHO_DI_JAVA_OPTIONS="-Xms512m" "-Xmx2048m

防止大数据量处理时内存溢出

(三)启动与界面导航

三、核心功能实操演示

(一)构建第一个数据转换

案例:将CSV数据导入MySQL

1. 新建转换 → 拖入`CSV文件输入`和`表输出`组件

2. 配置CSV路径与字段分隔符,预览数据结构

3. 创建数据库连接,填写目标表名与字段映射关系

4. 按住Shift键连接组件箭头,按F9执行转换

(二)定时任务调度

1. 新建作业 → 添加`START`触发器与`转换`任务

2. 设置定时规则(如每天凌晨1点执行)

3. 日志监控:查看`执行结果`面板的输出详情

四、安全性与最佳实践

(一)数据安全保障

1. 连接加密:支持SSL/TLS协议配置数据库加密连接

2. 凭据管理:使用`kettle.properties`存储加密后的账号密码

3. 权限控制:通过资源库模式实现多用户操作审计

(二)常见问题排查

1. 驱动加载失败:检查lib目录是否存在冲突的jar包版本

2. 内存溢出:修改`spoon.bat`中的-Xmx值为物理内存的70%

3. 中文乱码:在数据库连接URL后添加`useUnicode=true&characterEncoding=UTF-8`

五、用户评价与发展趋势

根据开发者社区反馈,Kettle的优势集中在灵活的数据处理能力和丰富的插件生态,但学习成本较高(平均需20小时掌握基础)。未来版本将重点增强实时数据流处理和云原生集成能力,与Kafka、Snowflake等平台深度融合。

对于企业用户,建议评估社区版与商业版的功能差异:社区版适合中小型离线批处理场景,而需要集群管理、血缘分析等高级功能时,可考虑Pentaho商业授权。

扩展阅读:

> 本文操作步骤已在Windows 11 + JDK 11环境中验证,适用版本:pdi-ce-9.4.0.0-343。历史版本兼容性说明请参考Pentaho官方文档。