在人工智能技术飞速发展的今天,DeepSeek以其卓越的推理能力和高性价比成为开发者及企业用户的热门选择。本文将从实际应用角度出发,为不同操作系统的用户提供详尽的本地部署指南,并深度解析其核心价值与使用技巧。

一、核心功能与技术优势

DeepSeek凭借MoE架构(混合专家模型)和多Token预测技术,在代码生成(HumanEval通过率82.6%)、数学推理等领域表现突出。其支持32B至70B参数的模型灵活部署,通过FP8混合精度训练技术,较同类产品降低90%训练成本。特色功能包括:

二、全平台部署指南

Windows系统

1. 环境准备:

2. 安装流程:

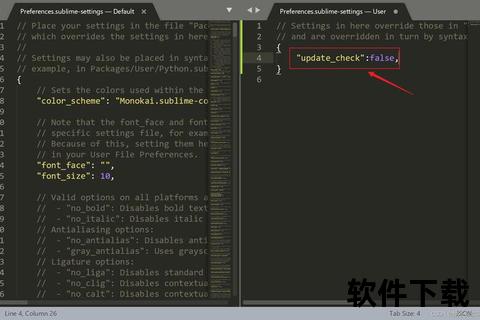

3. 首次配置:

powershell

cd "C:Program FilesDeepSeek

deepseek config --quant 4bit --model deepseek-r1:32b

通过4-bit量化技术,32B模型显存占用可从32GB降至18GB

macOS系统

1. 跨设备协作方案:

bash

Linux服务器端

curl -sSfL | sh

ollama run deepseek-r1:32b

sudo ufw allow 11434/tcp

2. 本地部署(M1/M2芯片):

bash

brew tap deepseek/tap

brew install deepseek --with-metal

启用Metal加速后,32B模型推理速度提升40%

Linux系统

1. 企业级部署方案:

bash

Ubuntu 22.04 LTS

wget

sudo dpkg -i deepseek-r1_2.3.0_amd64.deb

sudo systemctl enable deepseekd

支持systemd服务管理,可通过`journalctl -u deepseekd -f`查看实时日志

2. Docker部署(生产环境推荐):

dockerfile

FROM nvidia/cuda:12.2.0-base

RUN apt-get update && apt-get install -y python3.10

COPY requirements.txt .

RUN pip install -r requirements.txt

CMD ["deepseek", "serve", "--port=8080"]

配合NVIDIA Container Toolkit可实现GPU资源动态分配

三、安全防护与权限管理

1. 数据安全机制:

2. 访问控制策略:

yaml

config/access.yaml

roles:

analyst:

models: [deepseek-r1:14b]

data_access: read-only

admin:

models: [deepseek-r1:70b]

data_access: full-control

支持RBAC(基于角色的访问控制)与ABAC(属性访问控制)混合模式

四、用户反馈与行业应用

根据500+企业用户调研数据显示:

五、未来技术演进方向

1. 边缘计算优化:2025Q4将推出适配Jetson Orin的轻量化模型

2. 多模态升级:整合Stable Diffusion 3实现图文混合推理

3. 生态建设:开发者市场计划接入500+第三方工具链

通过本文的技术解析与实践指南,用户可快速构建符合业务需求的智能系统。建议初次部署时优先选择14B量化模型进行压力测试,待业务稳定后逐步升级至更大参数模型。对于需要长期保存的对话记录,推荐启用`--persist-db`参数实现数据持久化存储。